au sommaire

Alors qu'une intelligence artificielle (IAIA) prénommée Benjamin vient de faire preuve d'un certain talent en écrivant le scénario totalement loufoque d'un court-métrage de science-fiction intitulé Sunspring, voici qu'une autre IA se distingue dans le domaine du bruitage. Une équipe du CSAIL (Computer Science and Artificial IntelligenceIntelligence Laboratory)) au MIT (Massachusetts Institute of Technology) a développé un algorithme d'apprentissage profond (deep learning) capable d'analyser une vidéo muette et de réaliser les bruitages correspondant à l'action. Le programme s'est montré si efficace qu'il a réussi à leurrer des spectateurs en leur faisant croire que les sons d'un clip vidéo provenaient de l'environnement réel.

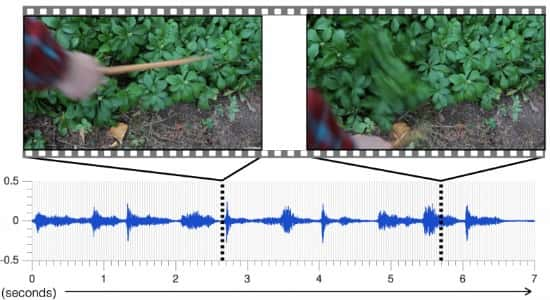

Dans un article intitulé Visually indicated sounds, qui sera présenté dans une dizaine de jours lors du Computer Vision and Pattern Recognition (évènement dédié aux technologies de vision par ordinateur), l'équipe du MIT explique sa démarche. L'apprentissage profondapprentissage profond reposant sur l'analyse d'une massemasse importante de données, les chercheurs ont commencé par créer une base répertoriant un millier de vidéos contenant environ 46.000 sons produits à partir d'une baguette de batterie. Pour reconnaître un son, l'IA doit déterminer quel type de matièrematière est touchée par la baguette et de quelle manière celle-ci entre en contact : est-ce qu'elle tape, tapote, gratte, racle, etc.

Pour cela, le programme analyse cette base de données pour décomposer les sons afin de déterminer leur hauteur, intensité, etc. Ensuite, pour choisir l'effet audio adapté à une action, l'algorithme étudie, image par image, les signaux audiovisuels bruts de la vidéo qu'on lui soumet. Puis il transforme ces échantillons en ondes pour les croiser avec la base de données afin de composer le son le plus adapté.

L’algorithme basé sur la technique d’apprentissage profond décompose chaque son pour en évaluer la hauteur, l’intensité... © Adam Conner-Simons, CSAIL (MIT)

L’IA a encore du mal avec la brise et le chant des oiseaux

Pour évaluer l'efficacité de leur IA, les spécialistes du CSAIL ont demandé à des volontaires de visionner deux vidéos, l'une contenant une bande son réelle, l'autre sonorisée par leur algorithme. Deux fois sur trois, les spectateurs ont identifié le son artificiel comme étant réel. L'IA a donc réussi l'équivalent d'un test de Turing pour le son, ce qui ouvre des perspectives prometteuses pour cette technologie.

Pour autant, le système a encore des limites qui l'empêchent de retranscrire n'importe quel bruit. Il faut que celui-ci puisse être rattaché à une action physiquephysique visuellement identifiable dans la séquence vidéo. Ainsi, l'IA n'est-elle pas capable de reconnaître le son de la brise, le gazouillis des oiseaux ou bien le ronronnement d'un ordinateur. Les illustrateurs sonores qui travaillent pour les films et les séries TV peuvent donc respirer. Du moins pour l'instant... Les chercheurs assurent en effet que de futures versions de cet algorithme pourraient un jour faire leur travail.

Par ailleurs, cette technologie aurait des applicationsapplications potentielles en robotique. D'après l'équipe du CSAIL, l'analyse des sons peut servir à déterminer les propriétés physiques des matériaux. Pour le vérifier, ils ont créé un autre algorithme capable de distinguer, à partir des sons qu'elles produisent, une surface dure d'une surface molle avec une précision de 67 %. Par exemple, en voyant un trottoir bordé d'herbe, un robot pourrait utiliser la référence sonore de ces deux surfaces pour savoir que l'une est dure et l'autre souple, et donc en déduire ce qui se passerait s'il devait marcher ou rouler sur l'une ou l'autre. Cette technique pourrait aider les robots à « anticiper les conséquences de leurs interactions avec le monde », estiment les chercheurs.